Storm MCP 服务器与 Sionic AI 无服务器 RAG

韩国人

Storm MCP(模型上下文协议)服务器

Storm MCP(模型上下文协议)LLM LLM RAG RAG 人择模型上下文协议Claude 桌面 Storm 平台。

Sionic AI Storm 平台https://sionicstorm.ai API 令牌 我想知道 是的。

使用

API Key 在scripts/run.sh中export STORM_API_KEY=''使用它。

请选择

带来不便敬请谅解。

消息:消息(send_nonstream_chat、list_agents、list_buckets、upload_document_by_file)。

파일 관리 : 파일 업로드, 읽기 및 관리를 위한 파일 시스템 작업을 구현합니다.

API 服务:Storm API 服务。

专业培训

main.py :MCP 代码。

core/file_manager.py :文件

FileSystemManager。core/internal_api.py :Storm REST API。

tools/tool_definitions.py :MCP 设置。

tools/tool_handlers.py :处理程序。

tools/tool_upload_file.py :MCP 下载文件。

阿基查恩

MCP(法学硕士)、(法学硕士)、(法学硕士)Storm MCP Storm MCP LLM 版本。

如何开始

Claude 桌面MCP

打开安装文件

JSON 文件名 MCP 文件名:

Related MCP server: Raccoon AI MCP Server

日本人

Storm MCP(模型上下文协议)服务器

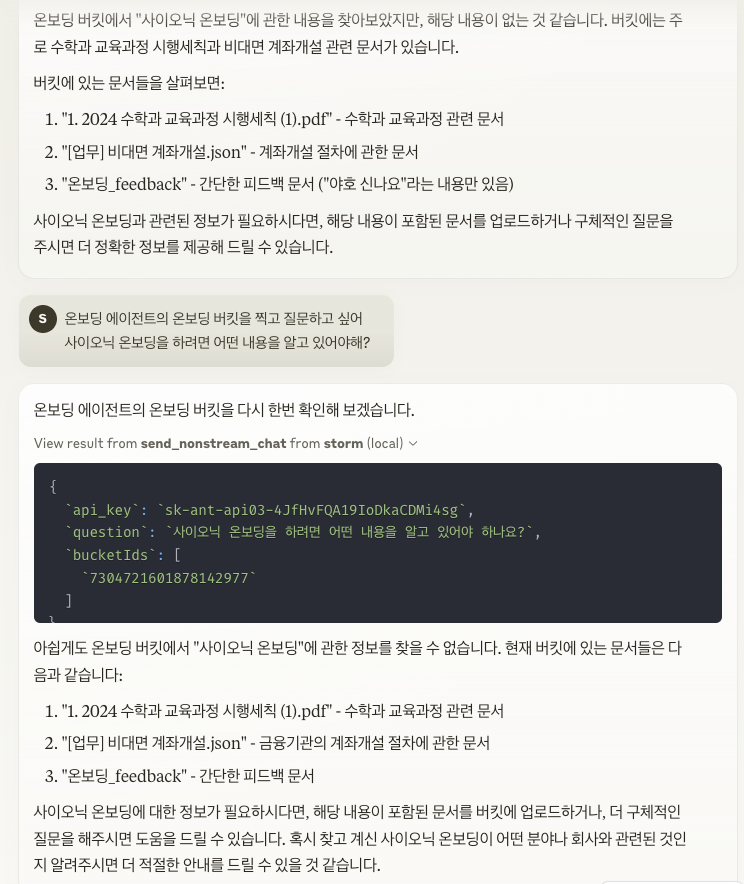

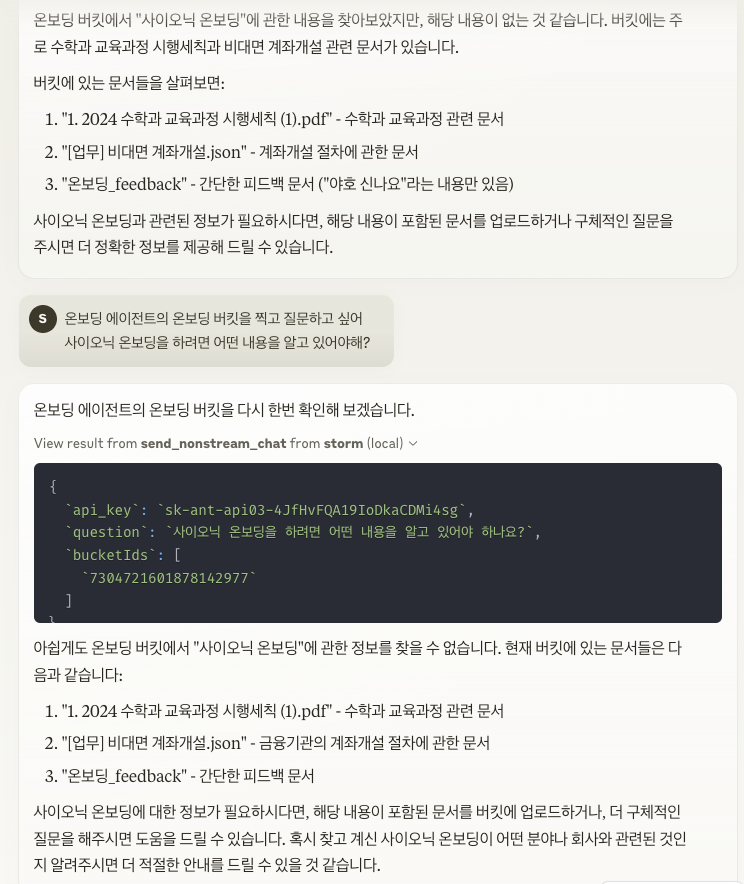

Storm MCP(模型上下文协议)服务器是一种开放协议,可实现 LLM 应用程序与 RAG 数据源和工具之间的无缝集成。它实现了 Anthropic 的模型上下文协议,允许您直接在 Claude Desktop 中使用 Storm 平台。

通过与Sionic AI的Storm平台集成,您可以连接并使用您自己的强大的嵌入式模型和矢量数据库产品。您可以按代理在https://sionicstorm.ai上注册以获取 API 令牌并立即创建您的 RAG 解决方案。

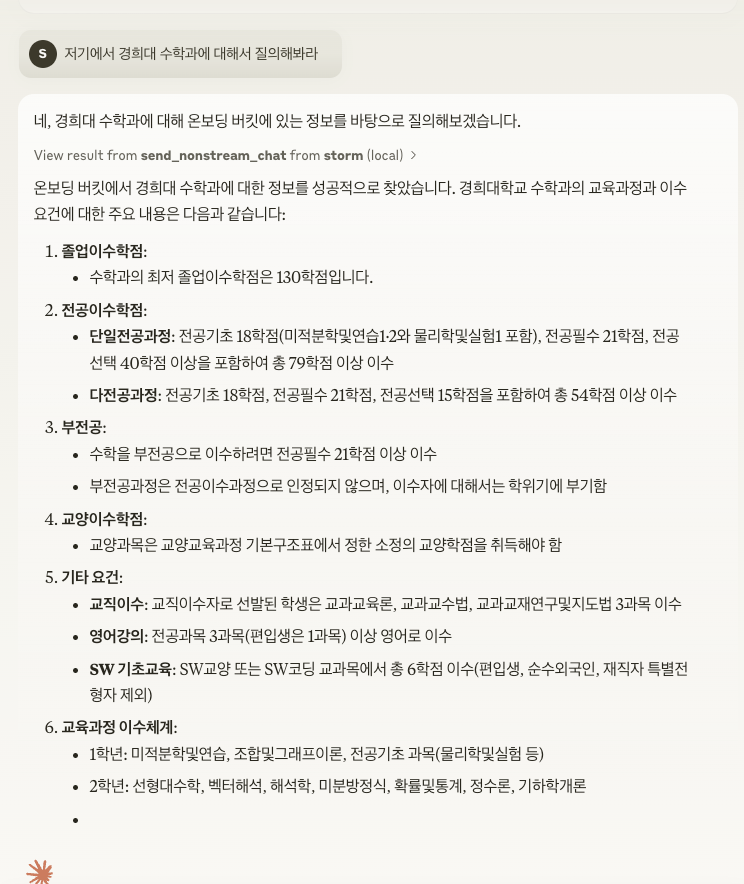

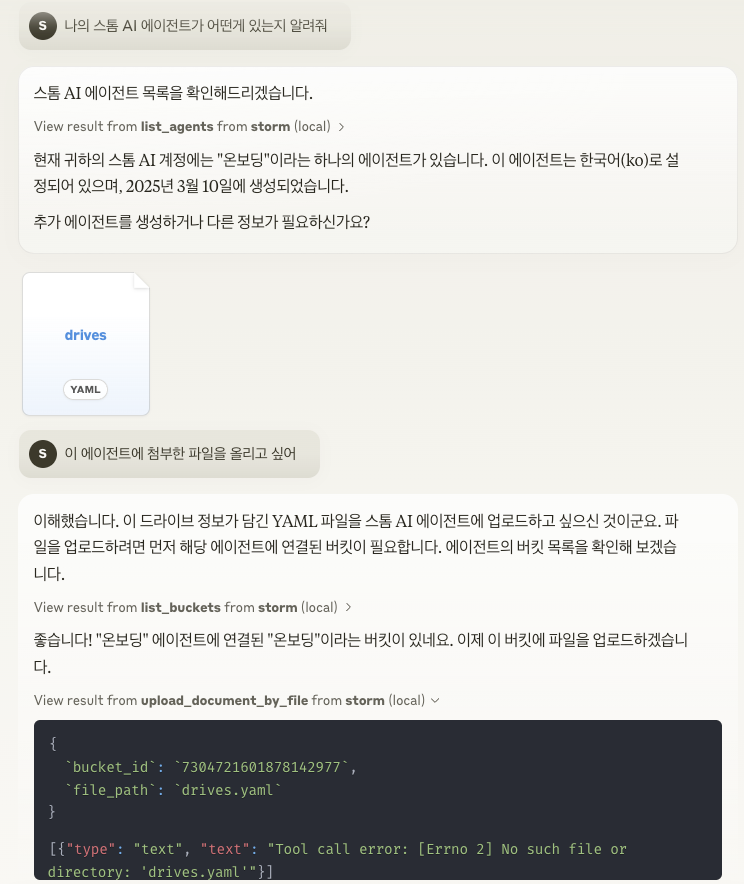

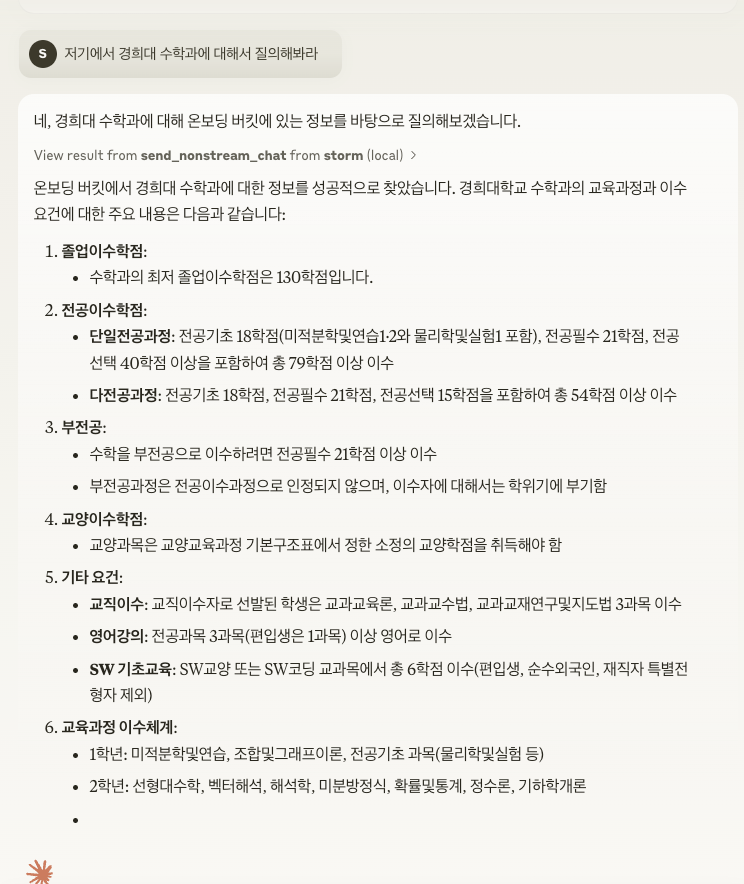

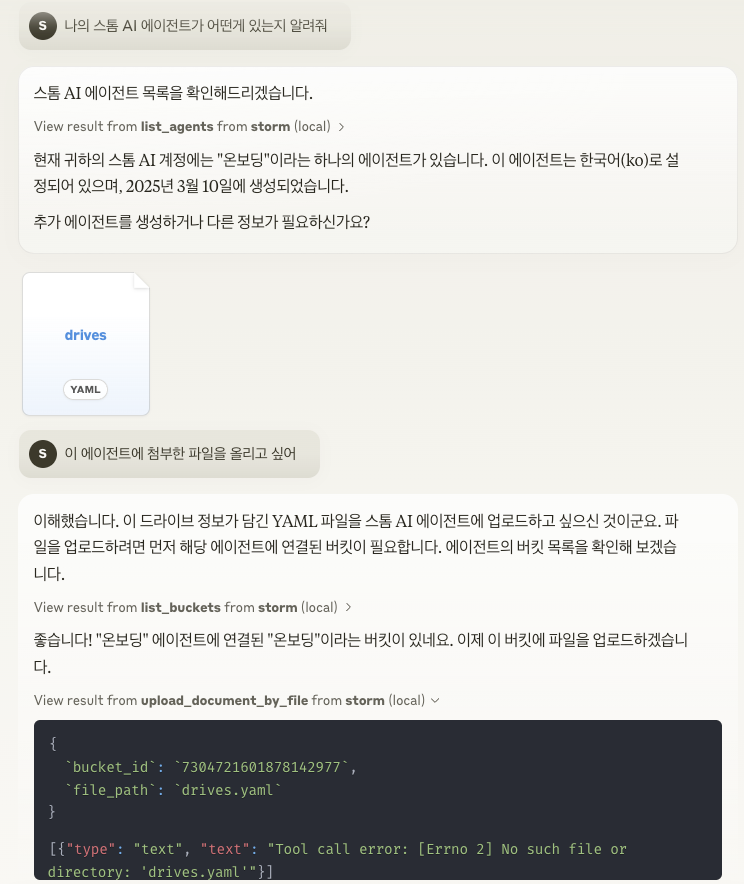

使用示例

请在scripts/run.sh中的export STORM_API_KEY=''中输入 API 密钥。

主要特点

上下文共享:为LLM和数据源之间的交互提供标准协议。

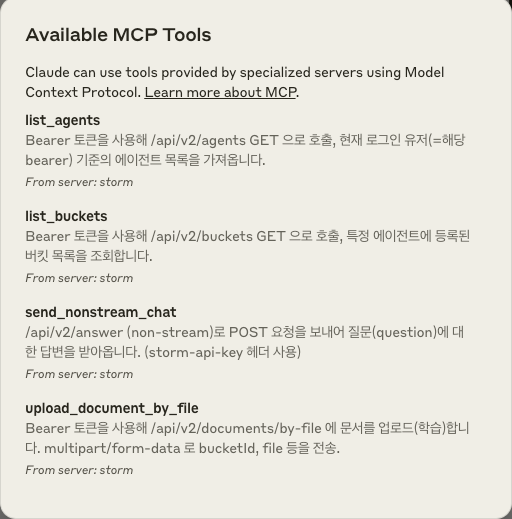

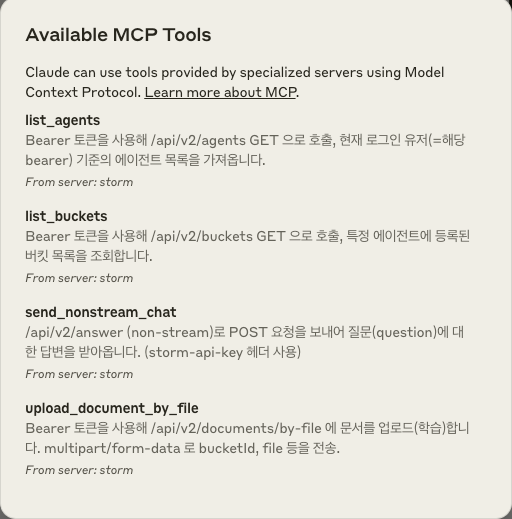

工具系统:提供定义和调用工具(send_nonstream_chat、list_agents、list_buckets、upload_document_by_file 等)的标准化方法。

文件管理:实现文件系统操作,包括文件的上传、读取和管理。

API 集成:连接到 Storm 的 API 端点以提供各种功能。

项目结构

main.py :初始化 MCP 服务器并设置事件处理程序。

core/file_manager.py :实现用于文件操作的

FileSystemManager类。core/internal_api.py :包含用于与 Storm 的 REST API 端点交互的 API 客户端函数。

tools/tool_definitions.py :定义 MCP 服务器上可用的工具。

tools/tool_handlers.py :实现工具操作的处理程序。

tools/tool_upload_file.py :使用自己的 MCP 处理程序为文件操作实现单独的文件服务器。

建筑学

MCP 采用主机(LLM 应用程序)、客户端(协议实现)、服务器(功能提供方)三层结构设计。 Storm MCP 服务器实现了其中的服务器部分并为 LLM 提供资源和工具。

如何开始

要在Claude Desktop环境中连接 MCP 服务器,必须应用以下设置:

打开配置文件

以 JSON 格式添加 MCP 服务器设置: