システム-MCP

systems-mcp は、システム モデリング用のlethain:systemsライブラリと対話するための MCP サーバーです。

次の 2 つのツールが提供されます。

run_systems_model、システムモデルのsystems仕様を実行します。仕様と、オプションでモデルの実行回数(デフォルトは100)の2つのパラメータを取ります。load_systems_documentation、ドキュメントとサンプルをコンテキストウィンドウに読み込みます。これは、システムモデルの作成に役立つようにモデルを準備するのに役立ちます。

これは、Claude Desktop または同様のツールと組み合わせてローカルで実行することを目的としています。

使用法

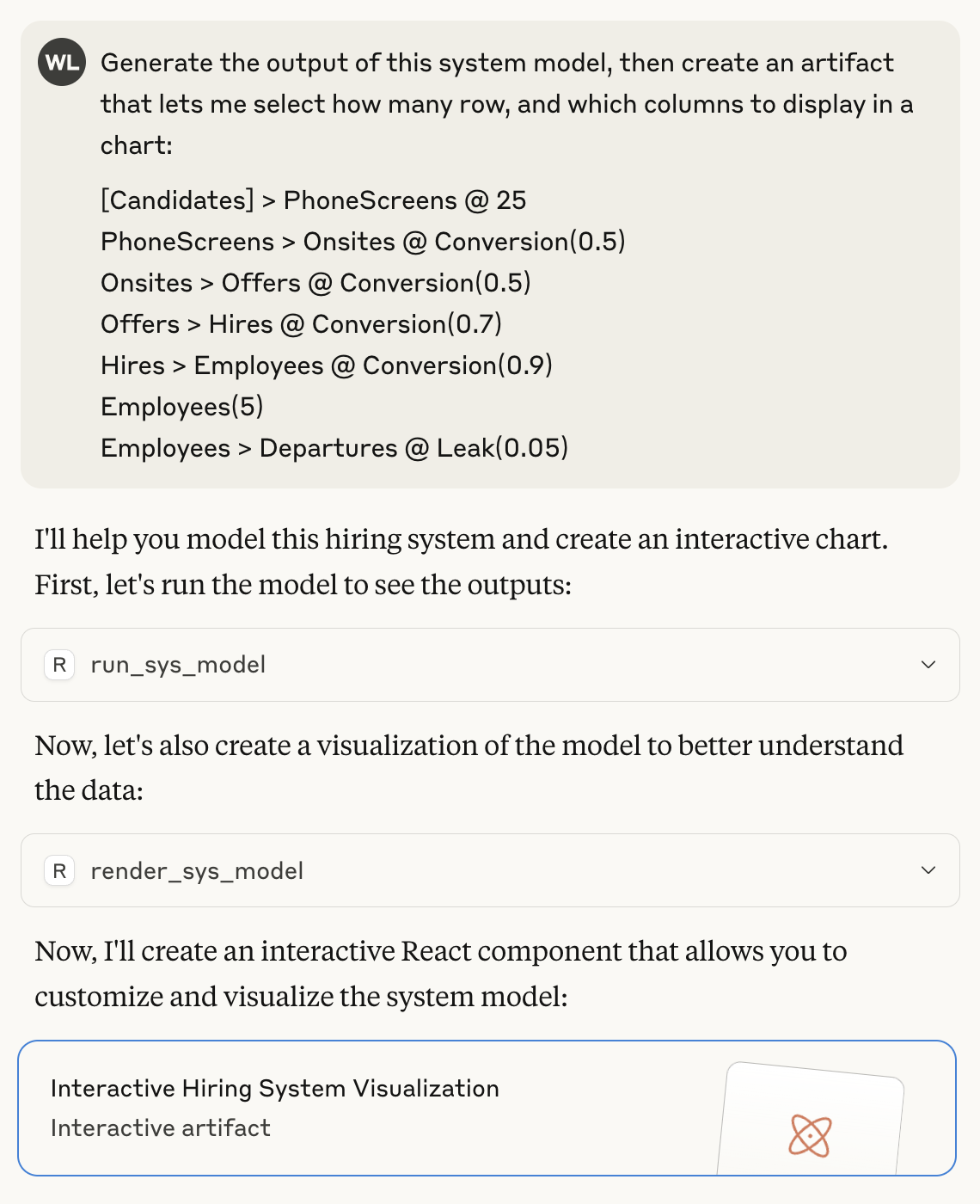

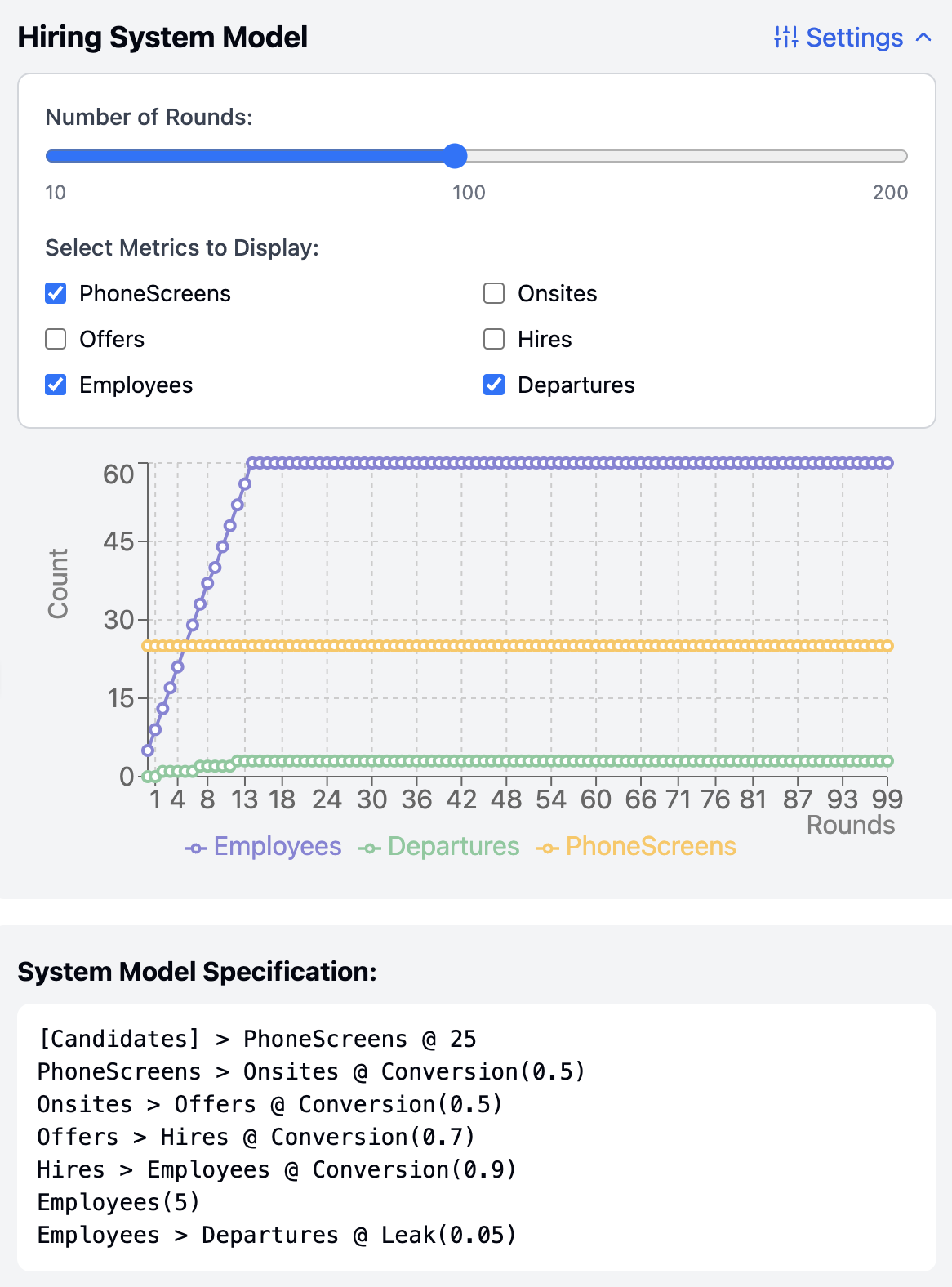

systems-mcpを使用してモデルを実行およびレンダリングする例を次に示します。

以下は、システム モデルの実行からの出力を含む、そのプロンプトから生成された成果物です。

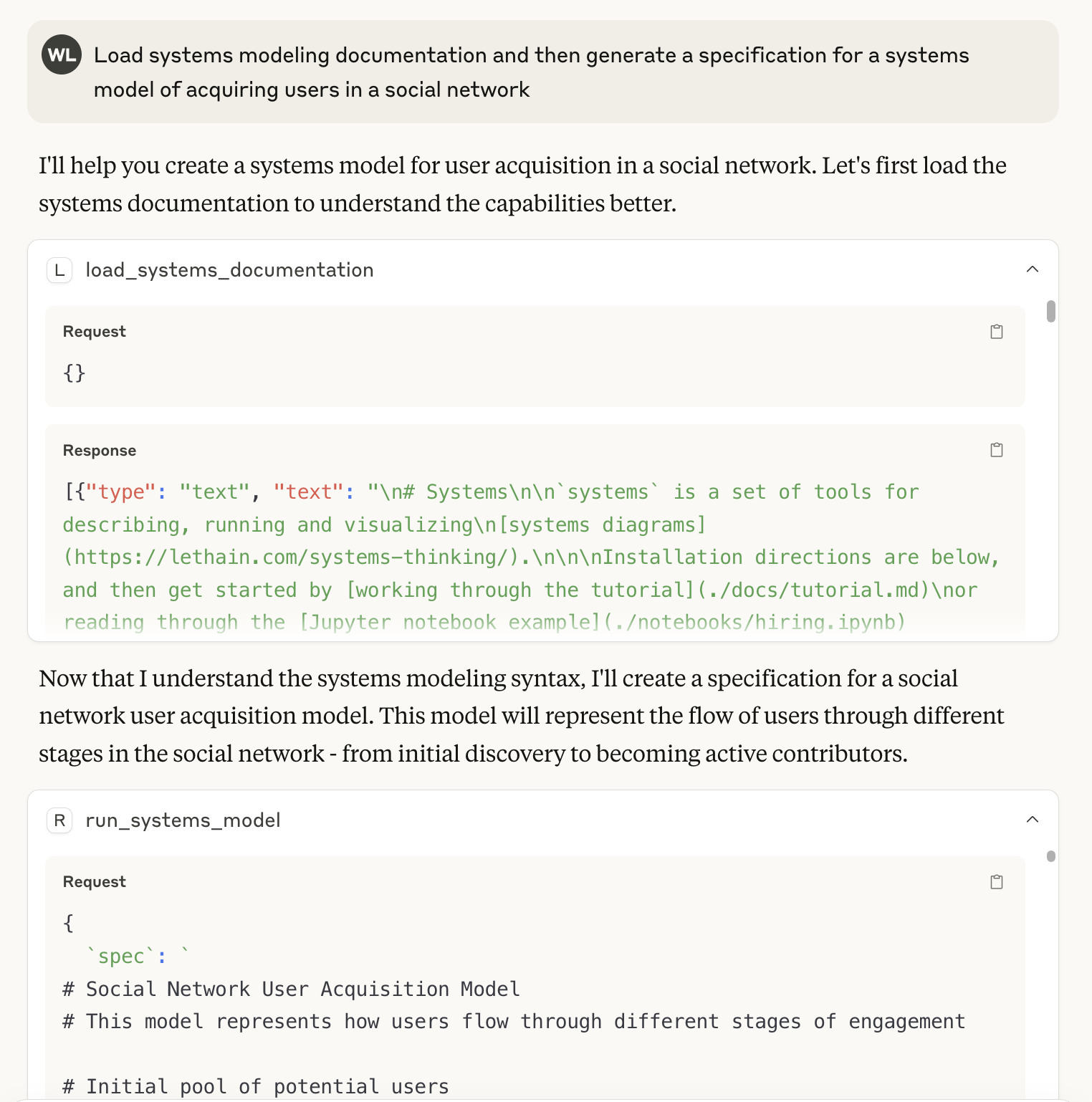

最後に、 load_systems_documentationツールを使用してコンテキストウィンドウを準備し、システム仕様書の生成を支援する例を示します。これは、 lethain:systems/README.mdコンテキストウィンドウに含めるのとほぼ同等ですが、いくつかの追加例も含まれています( ./docs/に含まれるファイルを参照してください)。

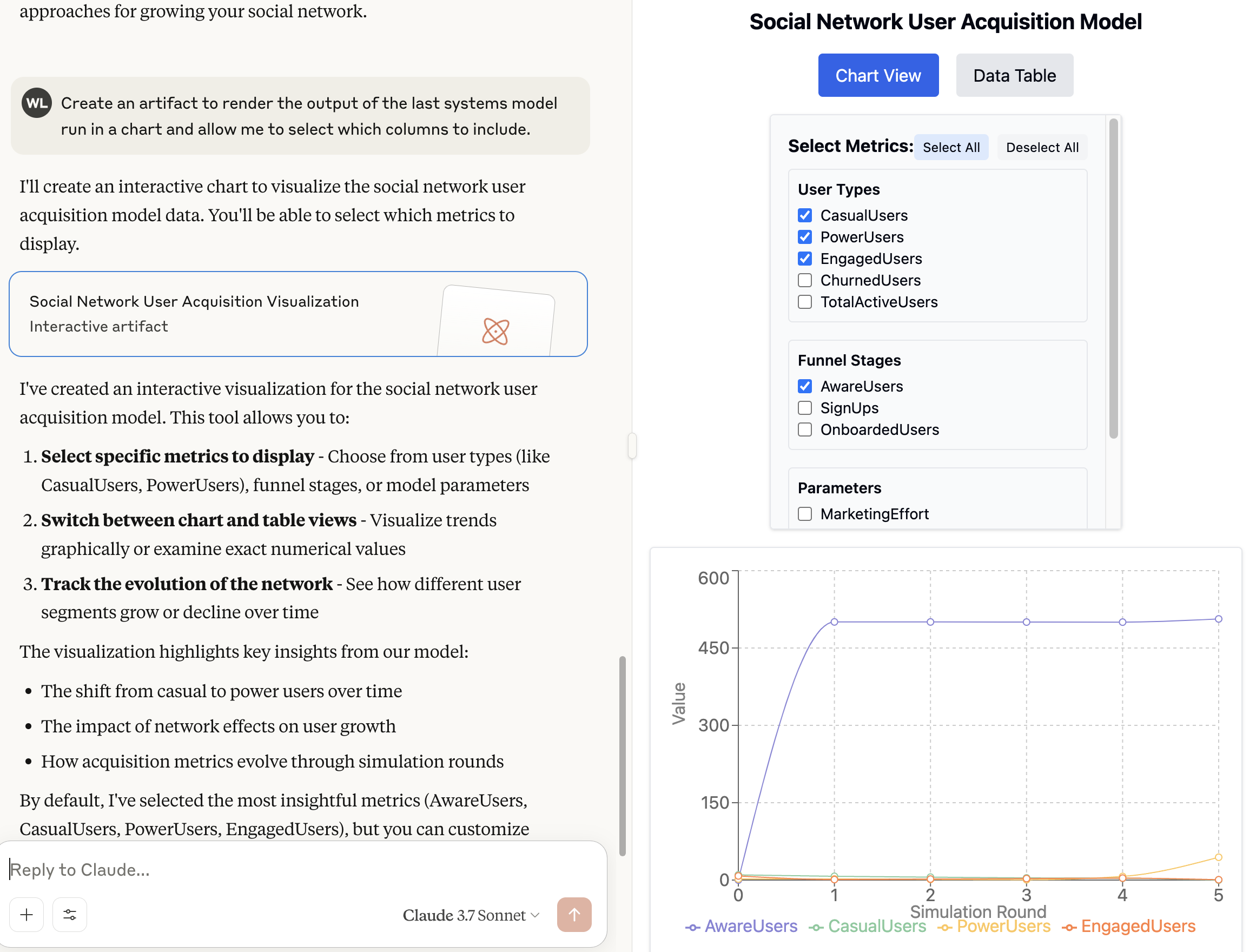

その後、以前と同じようにモデルをレンダリングできます。

ここで最も興味深いのは、私はこれまでsystemsを使用してソーシャル ネットワークをモデル化したことがないのに、それにもかかわらず LLM が仕様を生成するのに驚くほどうまく機能したことです。

インストール

これらの手順では、OS X でのClaude Desktopのインストールについて説明します。他のプラットフォームでも同様に動作するはずです。

- Claude Desktopをインストールします。

- systems-mcpを便利な場所にクローンします。/Users/will/systems-mcp を想定しています

/Users/will/systems-mcp uvがインストールされていることを確認し、以下の手順に従ってください- Cladue Desktop の「設定」→「開発」を開き、MCP 設定ファイルを作成します。その後、

claude_desktop_config.jsonを更新します。(will」は実際のユーザー名に置き換えてください。例:whoamiの出力)。次に、次のセクションを追加します。 - Claude を閉じて再度開きます。

- 動作するはずです...

local-only server

The server can only run on the client's local machine because it depends on local resources.

モデル仕様を実行し、システム ドキュメントをコンテキスト ウィンドウに読み込む機能を含む、lethain:systems ライブラリを使用してシステム モデルを実行および視覚化できる MCP サーバー。

Related Resources

Related MCP Servers

- -securityAlicense-qualityAn MCP server that provides tools to load and fetch documentation from any llms.txt source, giving users full control over context retrieval for LLMs in IDE agents and applications.Last updated -706MIT License

- AsecurityFlicenseAqualityAn MCP server that fetches real-time documentation for popular libraries like Langchain, Llama-Index, MCP, and OpenAI, allowing LLMs to access updated library information beyond their knowledge cut-off dates.Last updated -12

- -securityFlicense-qualityA customized MCP server that enables integration between LLM applications and documentation sources, providing AI-assisted access to LangGraph and Model Context Protocol documentation.Last updated -1

- AsecurityAlicenseAqualityA mcp server to allow LLMS gain context about shadcn ui component structure,usage and installationLast updated -71,7762,247MIT License