系统-mcp

systems-mcp是一个 MCP 服务器,用于与lethain:systems库交互以进行系统建模。

它提供了两个工具:

run_systems_model运行系统模型的systems规范。它接受两个参数:规范以及可选的运行轮数(默认为 100)。load_systems_documentation将文档和示例加载到上下文窗口。这对于准备模型非常有用,使其更有助于编写系统模型。

它旨在与 Claude Desktop 或类似工具一起在本地运行。

用法

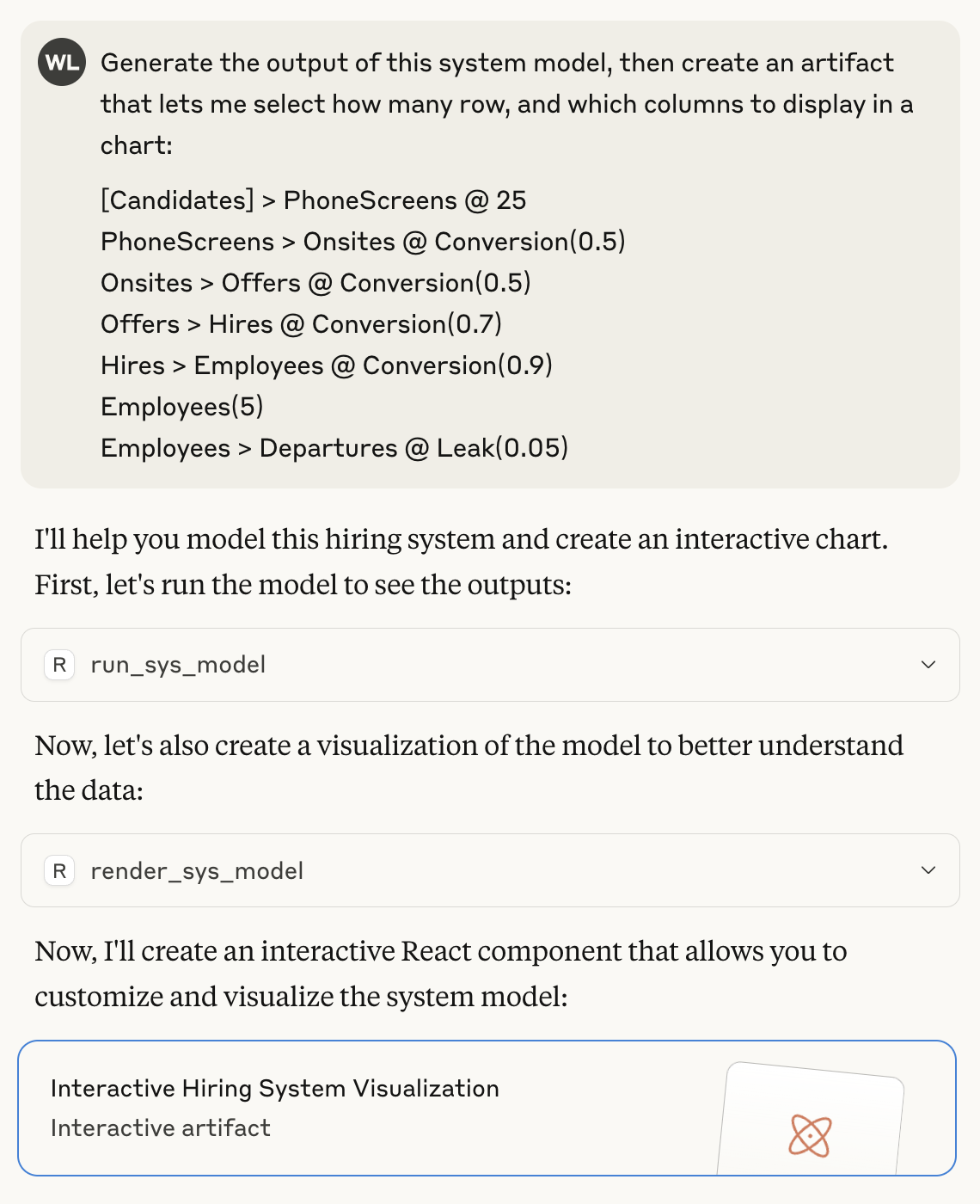

这是使用systems-mcp运行和渲染模型的示例。

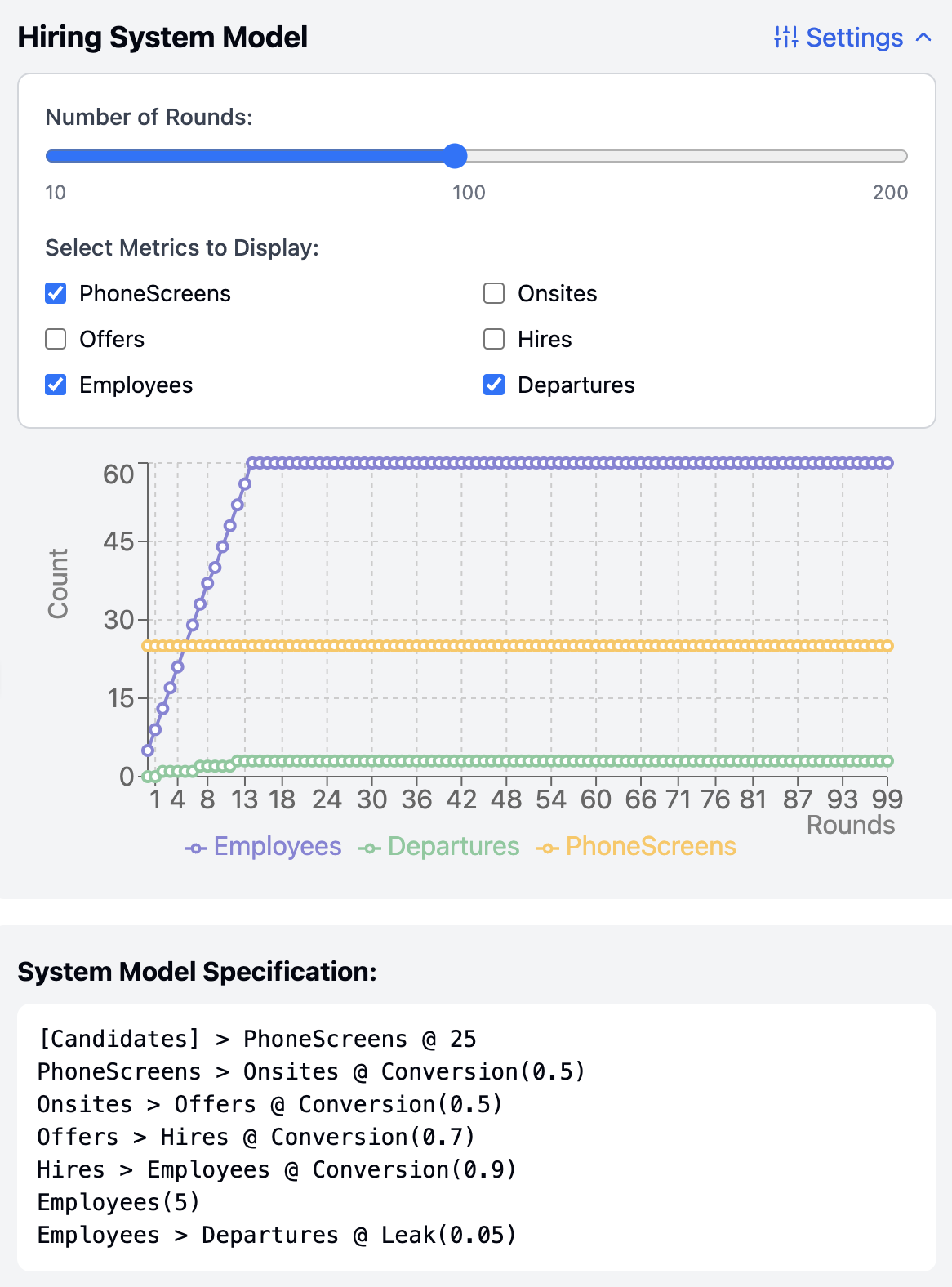

这是从该提示生成的工件,包括运行系统模型的输出。

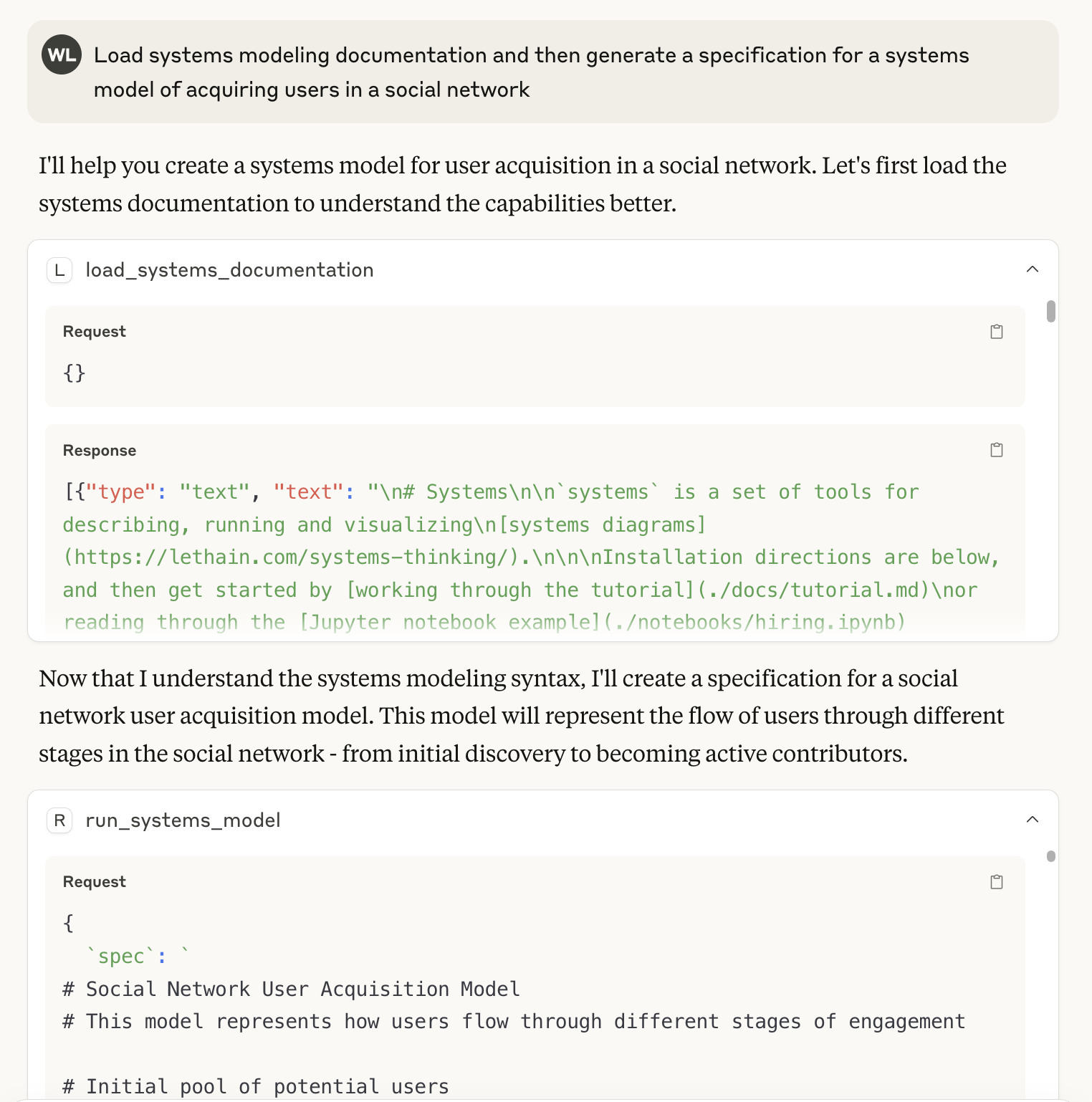

最后,这里有一个使用load_systems_documentation工具来启动上下文窗口并使用它生成系统规范的示例。这大致相当于在上下文窗口中包含lethain:systems/README.md ,但还包含了一些额外的示例(请参阅./docs/中的包含文件)。

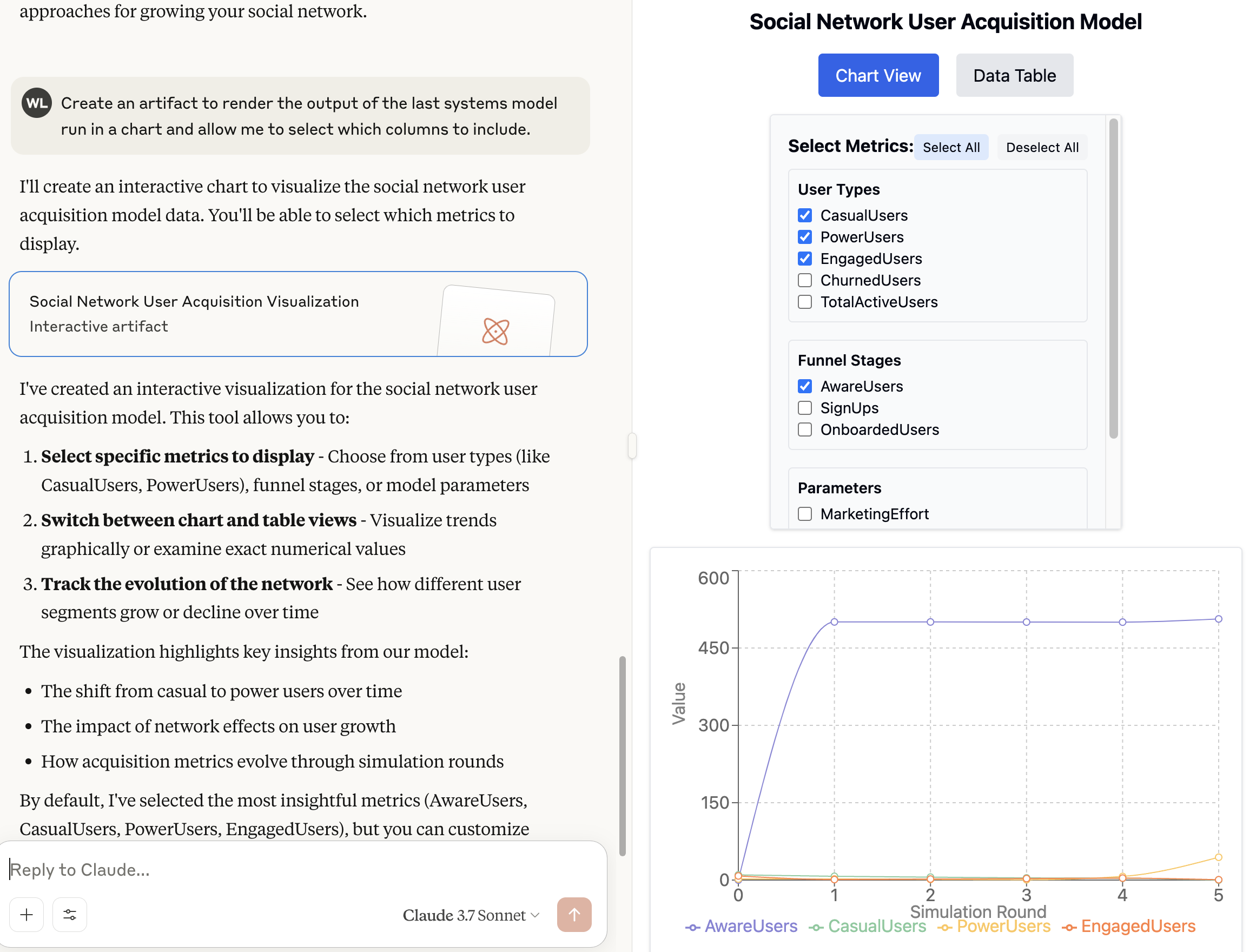

然后您可以像以前一样渲染模型。

这里最有趣的是,我个人从未使用过systems来模拟社交网络,但尽管如此,LLM 仍然能够出色地生成规范。

安装

这些说明描述了在 OS X 上安装Claude Desktop的方法。它在其他平台上应该可以类似地工作。

- 安装Claude Desktop 。

- 将systems-mcp克隆到一个方便的位置,我假设是

/Users/will/systems-mcp - 确保你已经安装了

uv,你可以按照这些说明进行操作 - 前往 Cladue Desktop,然后依次选择“设置”、“开发者”,并让其创建你的 MCP 配置文件。之后,你需要更新

claude_desktop_config.json文件。(注意,你应该将will替换为你的用户,例如whoami的输出。)然后添加此部分: - 关闭 Claude 并重新打开它。

- 它应该可以工作...

local-only server

The server can only run on the client's local machine because it depends on local resources.

MCP 服务器允许用户使用 lethain 库运行和可视化系统模型,包括运行模型规范和将系统文档加载到上下文窗口的功能。

Related Resources

Related MCP Servers

- -securityAlicense-qualityAn MCP server that provides tools to load and fetch documentation from any llms.txt source, giving users full control over context retrieval for LLMs in IDE agents and applications.Last updated -578PythonMIT License

- AsecurityFlicenseAqualityAn MCP server that allows AI models to execute system commands on local machines or remote hosts via SSH, supporting persistent sessions and environment variables.Last updated -167316TypeScript

- AsecurityFlicenseAqualityAn MCP server that fetches real-time documentation for popular libraries like Langchain, Llama-Index, MCP, and OpenAI, allowing LLMs to access updated library information beyond their knowledge cut-off dates.Last updated -12Python

- -securityFlicense-qualityA customized MCP server that enables integration between LLM applications and documentation sources, providing AI-assisted access to LangGraph and Model Context Protocol documentation.Last updated -1Python