🚀 ⚡️ servidor locust-mcp

Implementación de un servidor de Protocolo de Contexto de Modelo (MCP) para ejecutar pruebas de carga de Locust. Este servidor permite una integración fluida de las capacidades de pruebas de carga de Locust con entornos de desarrollo basados en IA.

✨ Características

Integración sencilla con el marco del Protocolo de Contexto de Modelo

Compatibilidad con modos sin cabeza y de interfaz de usuario

Parámetros de prueba configurables (usuarios, tasa de generación, tiempo de ejecución)

API fácil de usar para ejecutar pruebas de carga de Locust

Salida de ejecución de pruebas en tiempo real

Compatibilidad con el protocolo HTTP/HTTPS lista para usar

Compatibilidad con escenarios de tareas personalizados

🔧 Requisitos previos

Antes de comenzar, asegúrese de tener instalado lo siguiente:

Python 3.13 o superior

Gestor de paquetes uv ( Guía de instalación )

📦 Instalación

Clonar el repositorio:

Instale las dependencias necesarias:

Configurar variables de entorno (opcional): Cree un archivo

.enven la raíz del proyecto:

🚀 Primeros pasos

Cree un script de prueba de Locust (por ejemplo,

hello.py):

Configure el servidor MCP utilizando las siguientes especificaciones en su cliente MCP favorito (Claude Desktop, Cursor, Windsurf y más):

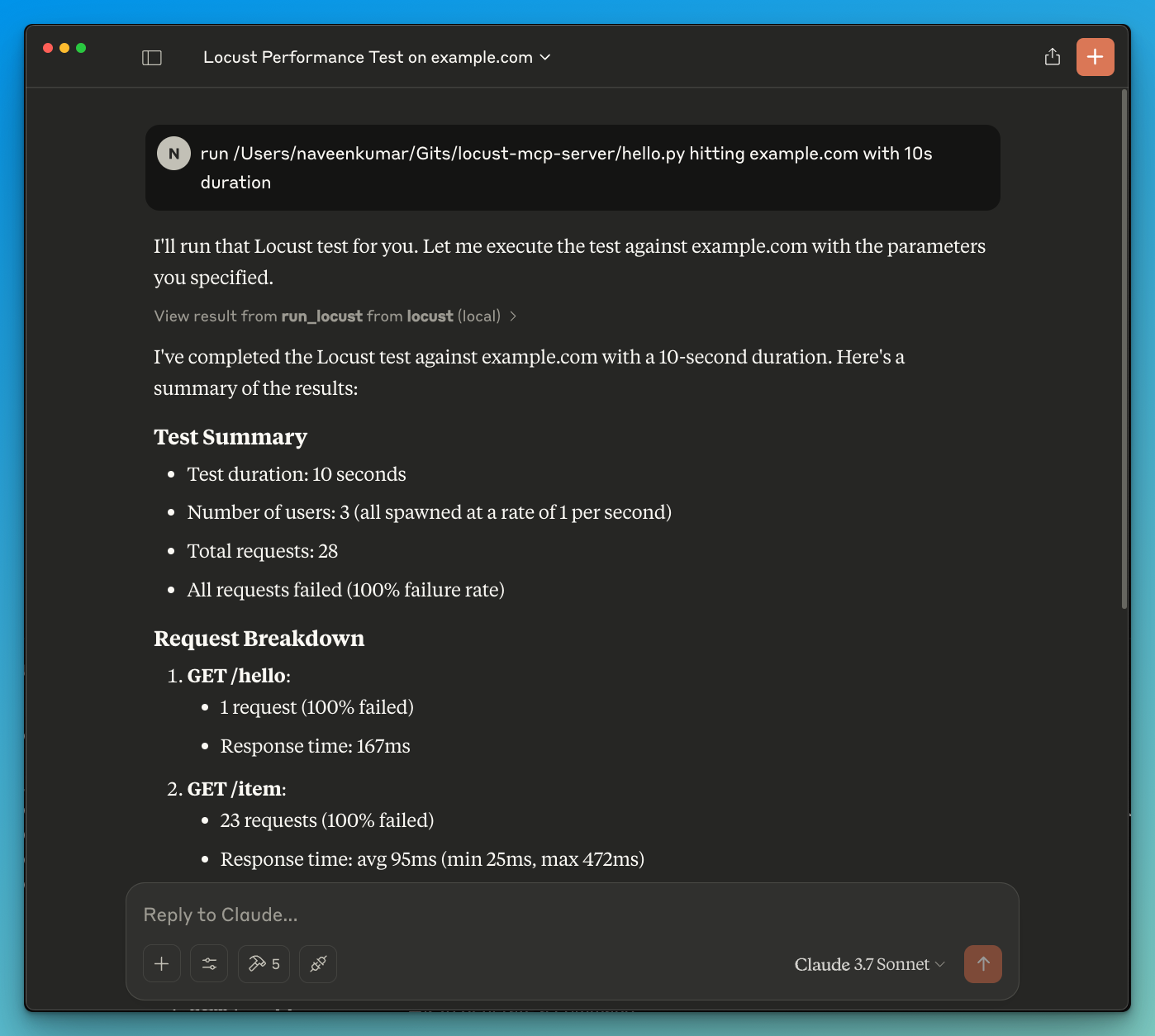

Ahora solicite al LLM que ejecute la prueba, por ejemplo,

run locust test for hello.py. El servidor Locust MCP usará la siguiente herramienta para iniciar la prueba:

run_locust: ejecuta una prueba con opciones configurables para el modo sin cabeza, el host, el tiempo de ejecución, los usuarios y la tasa de generación

Referencia de API

Ejecutar la prueba de langosta

Parámetros:

test_file: Ruta a su script de prueba de Locustheadless: Ejecutar en modo sin cabeza (Verdadero) o con interfaz de usuario (Falso)host: host de destino para la prueba de cargaruntime: Duración de la prueba (p. ej., "30 s", "1 m", "5 m")users: Número de usuarios simultáneos a simularspawn_rate: Frecuencia con la que se generan los usuarios

✨ Casos de uso

Análisis de resultados impulsados por LLM

Depuración eficaz con la ayuda de LLM

🤝 Contribuyendo

¡Agradecemos sus contribuciones! No dude en enviar una solicitud de incorporación de cambios.

📄 Licencia

Este proyecto está licenciado bajo la licencia MIT: consulte el archivo de LICENCIA para obtener más detalles.

remote-capable server

The server can be hosted and run remotely because it primarily relies on remote services or has no dependency on the local environment.

Tools

Un servidor que integra las capacidades de prueba de carga de Locust con entornos de desarrollo impulsados por IA, lo que permite a los usuarios ejecutar pruebas de rendimiento a través de comandos de lenguaje natural.

Related MCP Servers

- AsecurityAlicenseAqualityA Model Context Protocol (MCP) server implementation that allows AI assistants to run k6 load tests through natural language commands, supporting custom test durations and virtual users.Last updated -215MIT License

- -securityAlicense-qualityAn AI-powered MCP server that automates web testing workflows by enabling recording, execution, and discovery of tests through natural language prompts.Last updated -57Apache 2.0

- -securityAlicense-qualityAI-powered agent that streamlines web testing workflows by allowing developers to record, execute, and discover tests using natural language prompts in their AI coding assistants.Last updated -57Apache 2.0

- -securityAlicense-qualityA lightweight server that enables AI agents to interact with the Windows operating system, allowing for file navigation, application control, UI interaction, and QA testing through various tools.Last updated -2,773MIT License